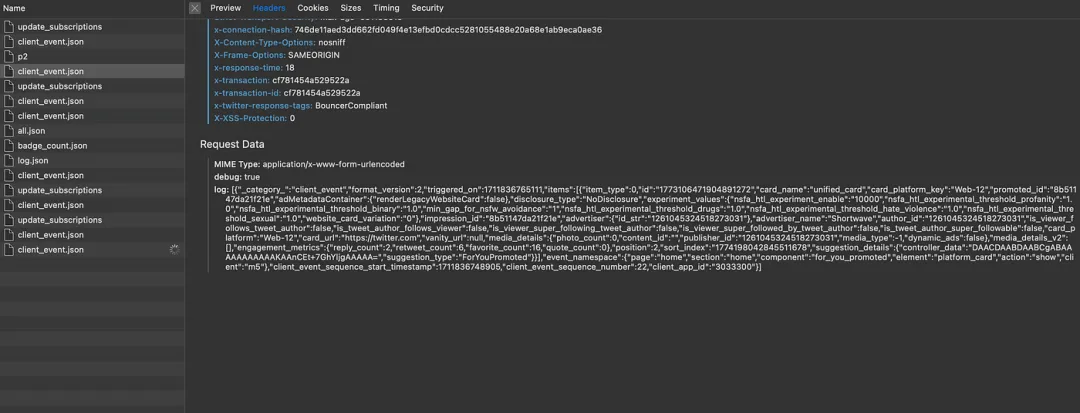

Twitter實時處理大約4000億事件,并每天生成一個PB(petabyte)的數據。Twitter從多種事件源消費數據,例如分布式數據庫、Kafka、Twitter事件總線等。

Twitter訂閱源中的事件調用示例

在這篇文章中,我們將嘗試理解:

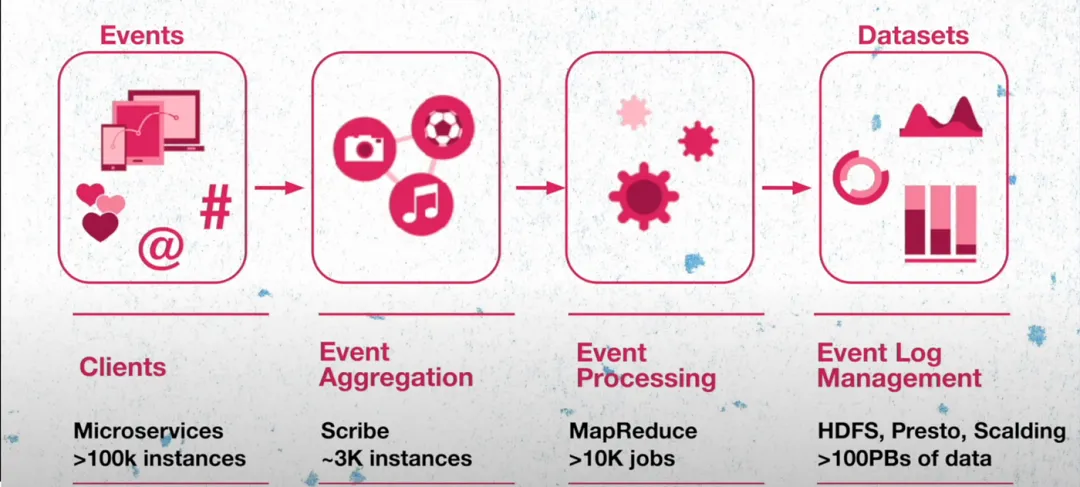

為了處理事件,Twitter有自己的一套內部工具,例如:

在我們深入了解事件系統如何演變之前,讓我們簡要了解一下這四種內部工具。

TimeSeriesAggregator:

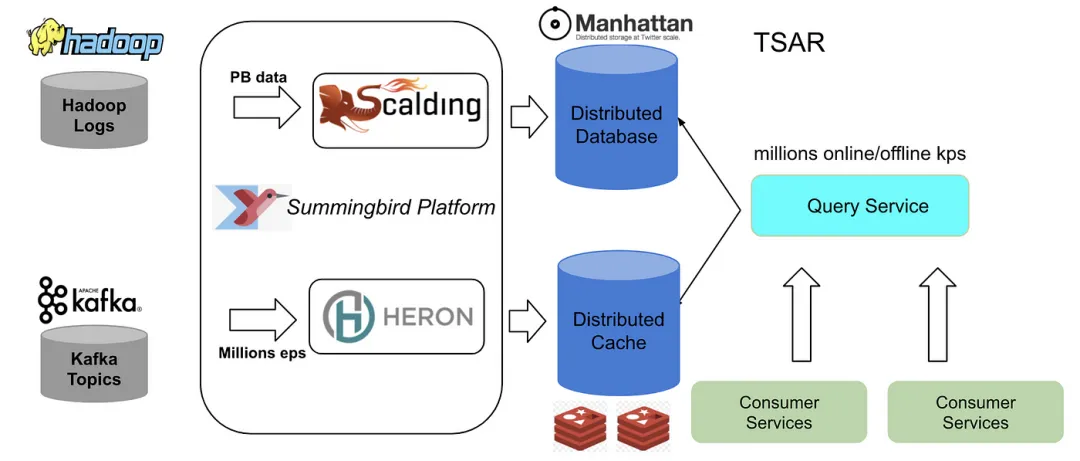

Twitter的數據工程團隊面臨著每天處理數十億事件的挑戰,無論是批處理還是實時處理。TSAR是一個健壯的、可擴展的、實時事件時間序列聚合框架,主要用于監控參與度:聚合與推文的互動,按多種維度(如設備、參與類型等)進行分段。

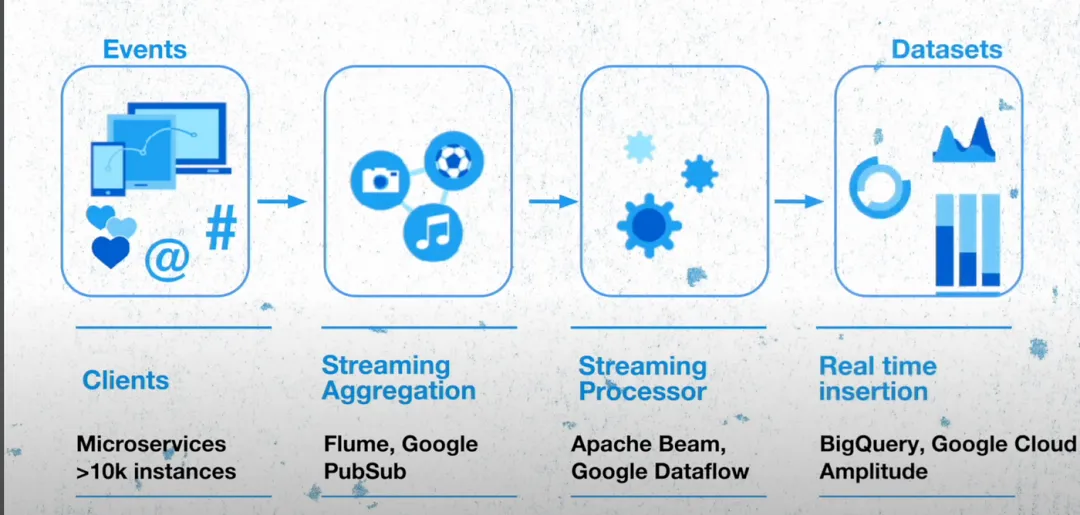

讓我們在非常高的層次上檢查Twitter的工作原理。所有Twitter功能都由遍布全球的微服務支持,包括超過10萬個實例。它們負責生成事件,這些事件被發送到事件聚合層,該層由Meta的一個開源項目構建。這一層負責對這些事件進行分組,運行聚合作業,并將數據存儲在HDFS中。然后處理這些事件,并進行格式轉換,重新壓縮數據,以創建格式良好的數據集。

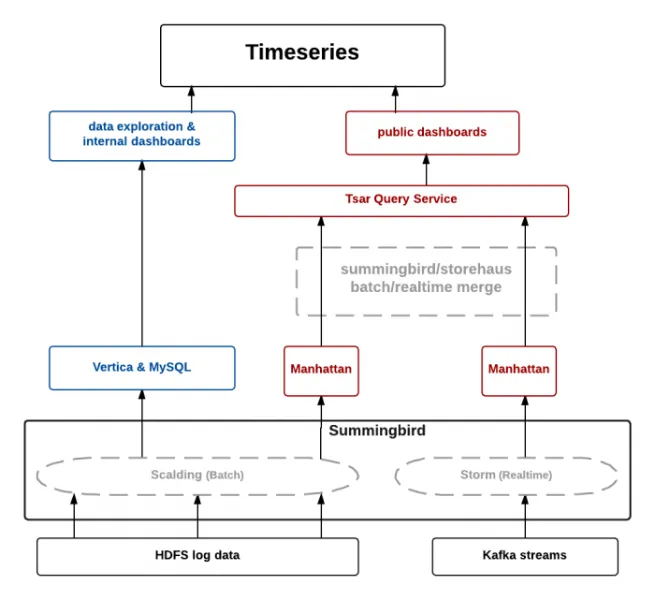

Twitter的舊架構基于lambda架構,它包括批處理層、速度層和服務層。批處理部分是由客戶端生成的日志,并在事件處理后存儲在Hadoop分布式文件系統(HDFS)上。Twitter構建了幾個擴展管道,用于預處理原始日志,并將它們作為離線源攝入到Summingbird平臺中。速度層的實時組件源是Kafka主題。

一旦數據被處理,批處理數據就存儲在Manhattan分布式系統中,而實時數據則存儲在Twitter自己的分布式緩存Nighthawk中。TSAR系統,如TSAR查詢服務,查詢緩存和數據庫,是服務層的一部分。

Twitter在三個不同的數據中心有實時管道和查詢服務。為了減少批處理計算成本,Twitter在一個數據中心運行批處理管道,并將數據復制到其他兩個數據中心。

你能想到為什么實時數據會存儲在緩存中而不是數據庫中嗎?

讓我們嘗試理解這種架構在實時事件處理中可能遇到的挑戰。

讓我們用一個例子來理解這一點:

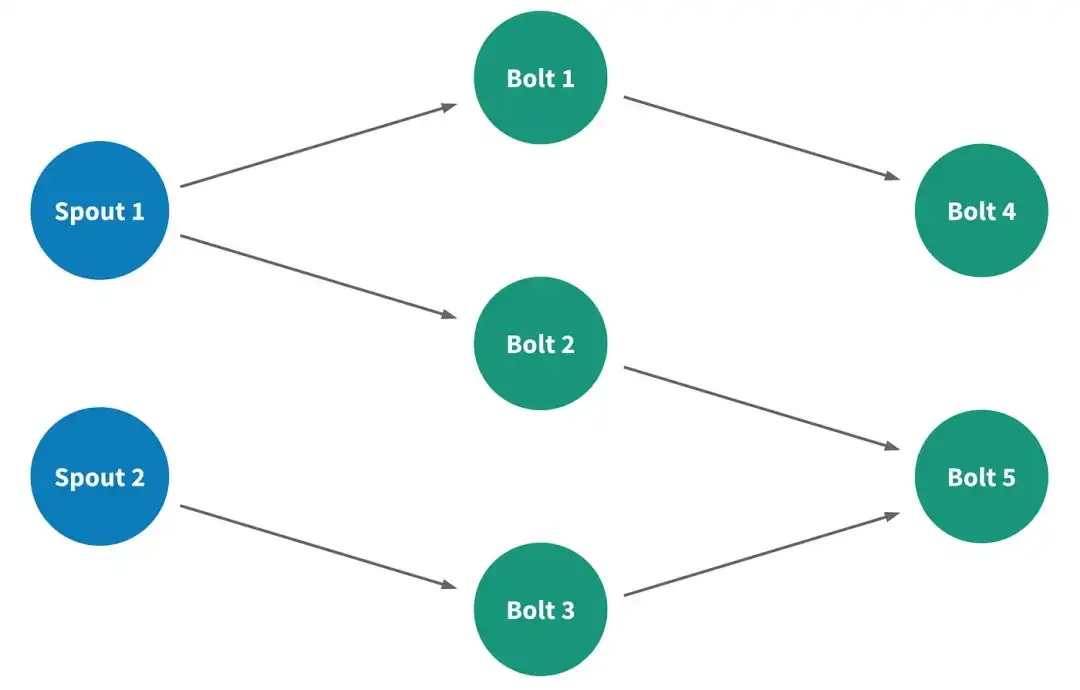

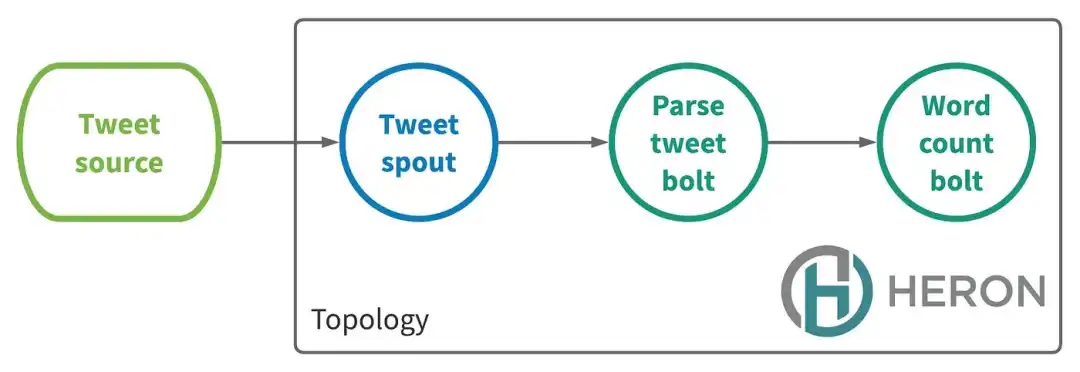

假設有一個大事件,如FIFA世界杯。推文源將開始向推文拓撲發送大量事件。解析推文的bolts無法及時處理事件,拓撲內部出現了背壓。當系統長時間處于背壓狀態時,heron bolts可能會積累spout滯后,這表明系統延遲高。Twitter觀察到,當這種情況發生時,拓撲滯后的下降需要很長時間。

團隊使用的操作解決方案是重啟Heron容器以重新開始處理流。這可能導致操作期間事件丟失,從而導致緩存中聚合計數的不準確。

現在讓我們嘗試理解批處理事件的例子。Twitter有幾個重計算管道處理PB級別的數據,并每小時運行一次,以將數據同步到Manhattan數據庫中。現在讓我們想象一下,如果同步作業需要超過一個小時,而下一個作業已經安排開始。這可能導致系統的背壓增加,并可能導致數據丟失。

正如我們所看到的,TSAR查詢服務整合了Manhattan和緩存服務,為客戶提供數據。由于實時數據可能丟失,TSAR服務可能會向客戶提供不準確的指標。

讓我們嘗試理解促使他們解決這個問題的客戶和業務影響:

現在,這意味著如果我們想根據用戶生成的事件更新用戶的時間線,或者根據用戶與Twitter系統的互動進行用戶行為分析,客戶將無法做到,因為他們需要等待批處理完成。

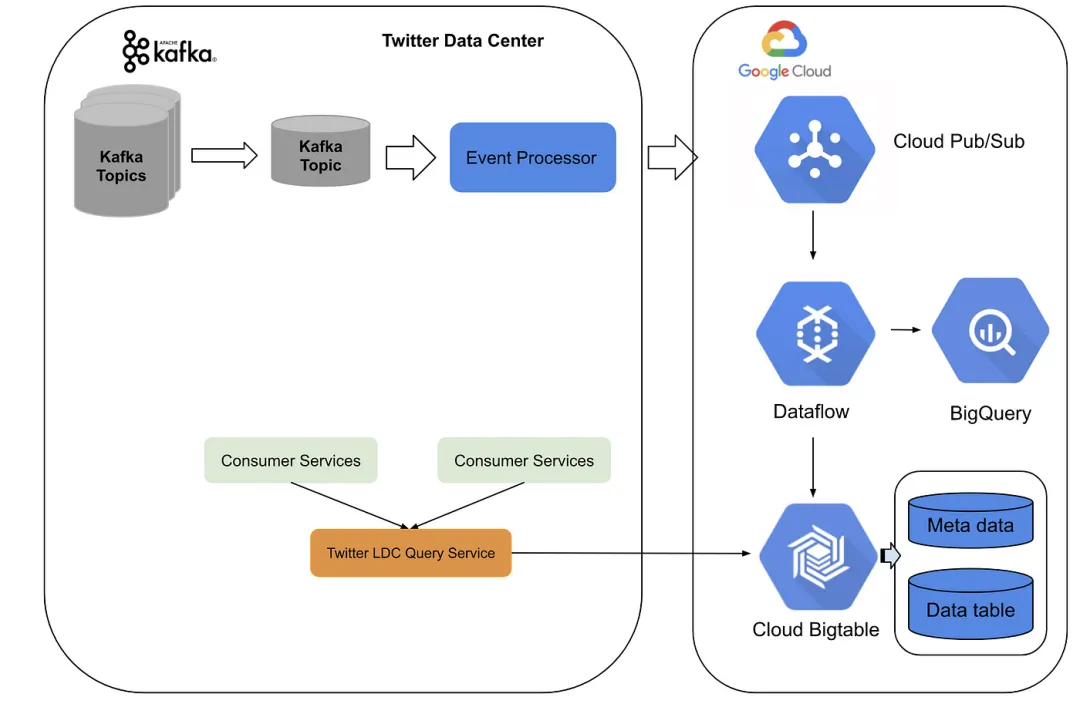

新架構建立在Twitter數據中心服務和Google Cloud平臺上。Twitter構建了一個事件處理管道,將kafa主題轉換為pub sub主題,然后發送到Google Cloud。在Google Cloud上,流數據流作業執行實時聚合,并將數據沉入BigTable中。

對于服務層,Twitter使用了一個在Twitter數據中心前端和Bigtable及Bigquery后端的LDC查詢服務。整個系統可以以低延遲(約10毫秒)流式處理每秒數百萬事件,并且在高流量期間可以輕松擴展。

這種新架構節省了構建批處理管道的成本,對于實時管道,Twitter能夠實現更高的聚合精度和穩定的低延遲。此外,他們不需要在多個數據中心維護不同的實時事件聚合。

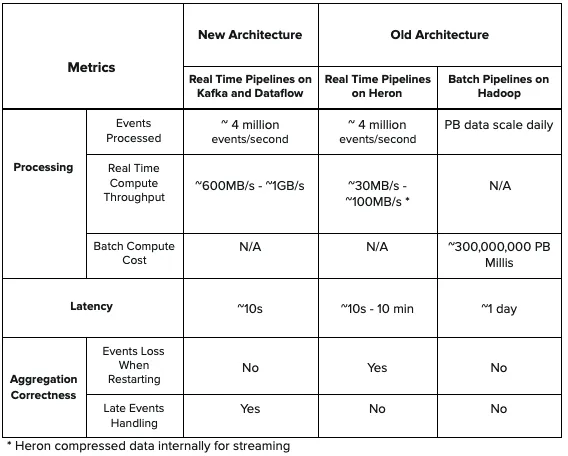

與舊架構中的Heron拓撲相比,新架構提供了更低的延遲,并提供了更高的吞吐量。此外,新架構處理了延遲事件計數,并且在進行實時聚合時不會丟失事件。更重要的是,新架構中沒有批處理組件,因此簡化了設計并減少了舊架構中存在的計算成本。

通過將基于TSAR的舊架構遷移到Twitter數據中心和Google Cloud平臺的混合架構,Twitter能夠實時處理數十億事件,并實現低延遲、高精度、穩定性、架構簡化和降低工程師的運營成本。

本文鏈接:http://www.tebozhan.com/showinfo-26-83612-0.htmlTwitter如何優化處理4000億事件的流程

聲明:本網頁內容旨在傳播知識,若有侵權等問題請及時與本網聯系,我們將在第一時間刪除處理。郵件:2376512515@qq.com

上一篇: 銘瑄科技出席 2024 英特爾網咖及電競酒店行業生態論壇 為電競生態貢獻力量

下一篇: Python的這個特性,省了我一大堆代碼